En informatique, un bit est l’unité de base de l’information, pouvant prendre l’une des deux valeurs binaires : 0 ou 1.

Toutefois, toute information, qu’elle soit textuelle, visuelle, sonore ou autre, peut être quantifiée en bits en dehors de l’informatique en utilisant des techniques de codage et de compression adaptées : ce n’est rien de plus qu’une unité de mesure de l’information.

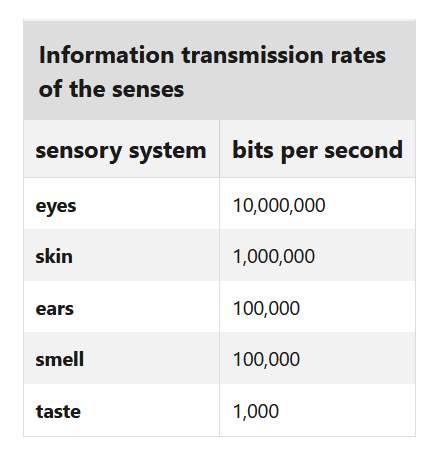

Ainsi, il a été démontré que les sens humains recueillent environ 11 millions de bits par seconde de l’environnement, mais l’esprit conscient semble être capable de ne traiter qu’environ 50 bits par seconde.

Cela est visible dans des activités comme la lecture, où un rythme typique de 300 mots par minute se traduit par environ 50 bits par seconde.

En revanche, les ordinateurs modernes peuvent traiter des milliards, voire des trillions de bits par seconde, dépassant de loin le taux de traitement conscient humain.

La différence entre la quantité d’informations transmises au cerveau (11 millions de bits par seconde) et la quantité traitée consciemment (50 bits par seconde) suggère qu’une énorme quantité de compression et de traitement inconscient se produit dans le cerveau.

D’un autre côté, Herbert Simon, Nobel d’économie en 1978 a proposé sa théorie de la « Rationalité limitée », dans celle-ci, il suggère que la capacité de décision d’un individu est altérée par un ensemble de contraintes comme le manque d’information (on retrouve les limites du cerveau humain), des biais cognitifs ou encore le manque de temps. Dans cette optique, les décideurs ont tendance à choisir des solutions satisfaisantes plutôt qu’optimales.

Cette théorie s’oppose clairement à la théorie du choix rationnel, qui postule l’acteur économique est pleinement rationnel concernant la situation envisagée.

Cependant, au lieu d’opposer les ordinateurs aux cerveaux humains, la rationalité limitée suggère que le développement des outils informatiques a permis de surpasser les limites humaines en termes de stockage et de traitement de l’information, un clin d’œil direct à l’émergence de l’intelligence artificielle, qui bénéficie de la capacité de traitement des ordinateurs, tout en simulant un raisonnement humain.